подробное описание создания, схемы и чертежи + (фото инструкция)

На сегодняшний период времени увеличивающие или уменьшающие трансформаторы применяются для изменения напряжения. Данное устройство является машиной с высоким уровнем КПД и используется в большинстве сферах техники. Нередко людей интересует, как создать каркас и другие части трансформатора собственноручно.

Чтобы выполнить подобную задачу не обойтись без специальных умений. Помимо этого важно быть в курсе всего технологического процесса.

Краткое содержимое статьи:

Создаём трансформатор

При необходимости сделать данный прибор, важно ответить на ряд вопросов, в том числе:

- Какое непосредственно напряжение должен он пропускать?

- На какой именно частоте планируется запустить в работу устройство?

- Для каких целей требуется аппарат: для снижения или увеличения тока?

Какую мощь будет иметь?

Как только вы сможете ответить на каждый из перечисленных вопросов, приобретайте требуемые материалы.

Трансформатор собственноручно требует намотку. В этих целях следует создать станок, изготовление которого осуществляется из доски длиною сорок сантиметров и шириною десять сантиметров. На доску необходимо прикрепить несколько брусков, посредством шурупов.

Расстояние, имеющееся между брусками не должно быть менее чем тридцать сантиметров. Затем следует просверлить отверстия восемь миллиметров диаметром. В созданные отверстия нужно вставить специальные пруты для катушки аппарата.

С одной из сторон следует создать резьбу. Закрутив обустроенную шайбу, вы получите его ручку. Габариты станка для намотки можно выбрать на собственное усмотрение. Прежде всего, правильный выбор напрямую зависит от габарита сердечника. При кольцевидной его форме намотка создаётся вручную.

Согласно схеме трансформаторного устройства, аппарат может быть оснащён разнообразным числом витков. Требуемое их количество рассчитывается, ориентируясь на мощность. К примеру, при необходимости создания прибора до 220 вольт, мощность должна достигать не менее 150 ватт.

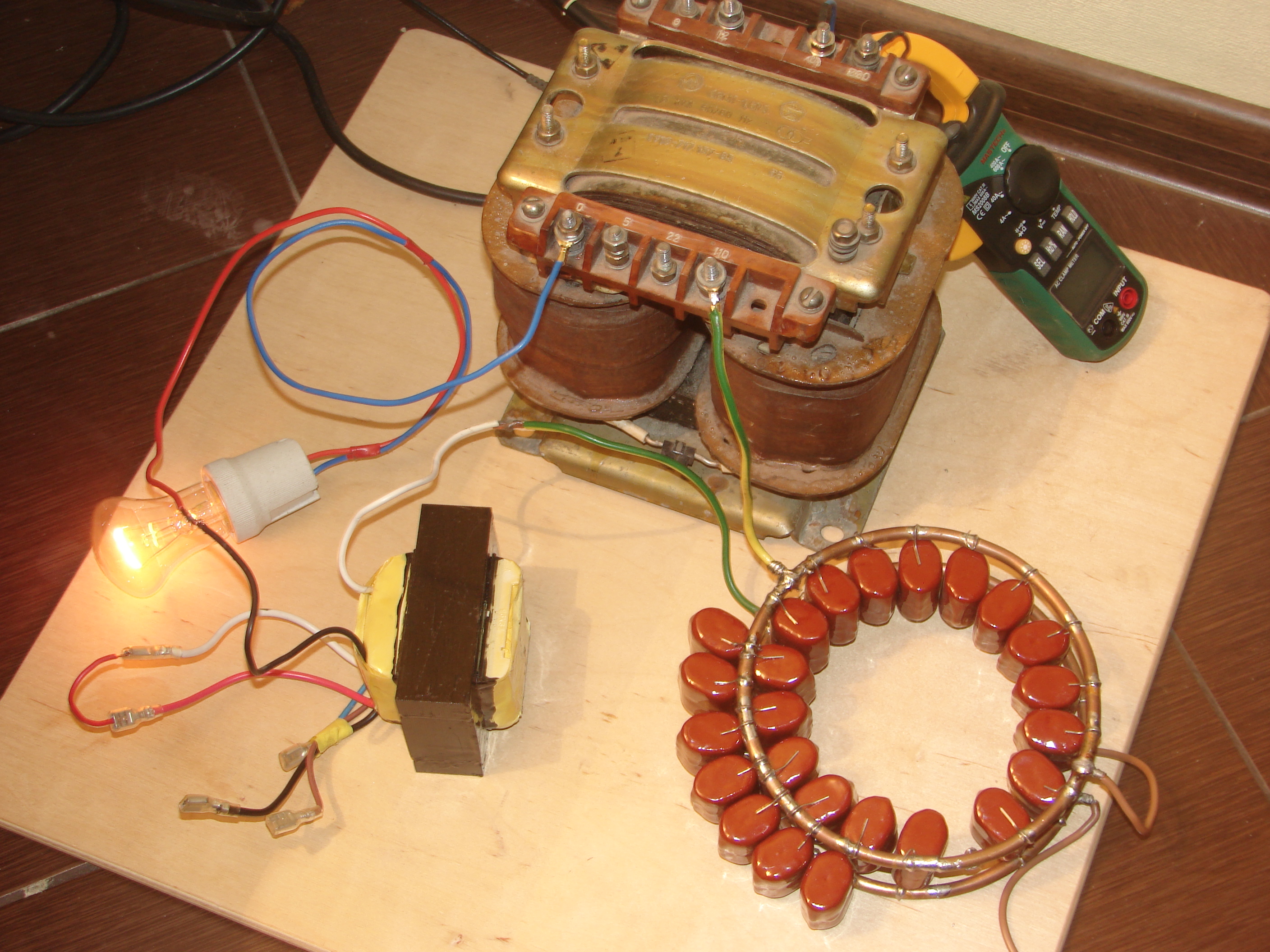

Форма магнитного провода должна быть о-образной. Можно обустроить его из бу телевизора. При этом сечение определяется посредством определённой формулы.

Обустройство катушечного корпуса

Корпус делают из качественной картонной бумаги. Внутренняя его сторона слега больше в сравнении со стержневой частью сердечника. При применении о-образного сердечника потребуется несколько катушек. При сердечнике ш-образном достаточно использовать всего одну катушку.

Применяя сердечник круглой формы, его следует обмотать, применяя изоляцию. Затем можно осуществлять проводную намотку. Как только вы завершите с обмоткой первичной, её следует закрыть несколькими изоляционными слоями.

После этого нужно накрутить очередной слой. Концы имеющихся обмоток выводятся на наружную сторону.

При применении магнитного провода корпус трансформатора собирается пошагово:

- Осуществляется выкраивание определённого размера гильзы с требуемыми отворотами.

- Создаются картонные щёчки.

- Основная часть катушки сворачивается в специальную коробочку.

- На гильзы надеваются щёчки.

Создание обмоток для увеличивающего трансформатора

Следует надеть катушку на брусок из натурального массива. В нём необходимо просверлить специальное отверстие для прутка намоточного.

К одному из серьёзных этапов относится подключение тока. Деталь вставляется внутрь станка и можно производить обмотку:

- Сверху катушки наматывается лакоткань в несколько слоёв.

- Конец имеющегося провода закрепляется на обустроенной щёчке, после чего можно приступать к вращению ручку.

- Витки укладываются максимально плотно.

- После обмотки следует обрезать провод для последующего закрепления сверху щёчки возле первого.

- На имеющиеся выводы необходимо закрепить трубку изоляционную.

Сборка трансформатора увеличивающего

При необходимости узнать, как создать собственноручно трансформатор, воспользуйтесь инструкцией. Для сборки повышающего устройства важно разобрать полностью сердечник. При применении отдельно размещённых пластин, важно определиться с пакетной толщиной, рассчитать листы.

В случае если в процессе включения аппарата будет издаваться шум, то необходимо закрепить имеющийся крепёж максимально плотно. Затем следует проверить прибор на работоспособность. В этих целях он подключается к сети, после чего должно высветиться напряжение, составляющее 12В.

Немаловажно знать, что в процессе включения аппарата, важно оставить его в работающем состоянии на пару часов. При этом трансформатор должен не перегреваться.

Инструменты

Чтобы изготовить трансформатор собственноручно, следует взять инструменты, а также определённые материалы:

- Лакоткань.

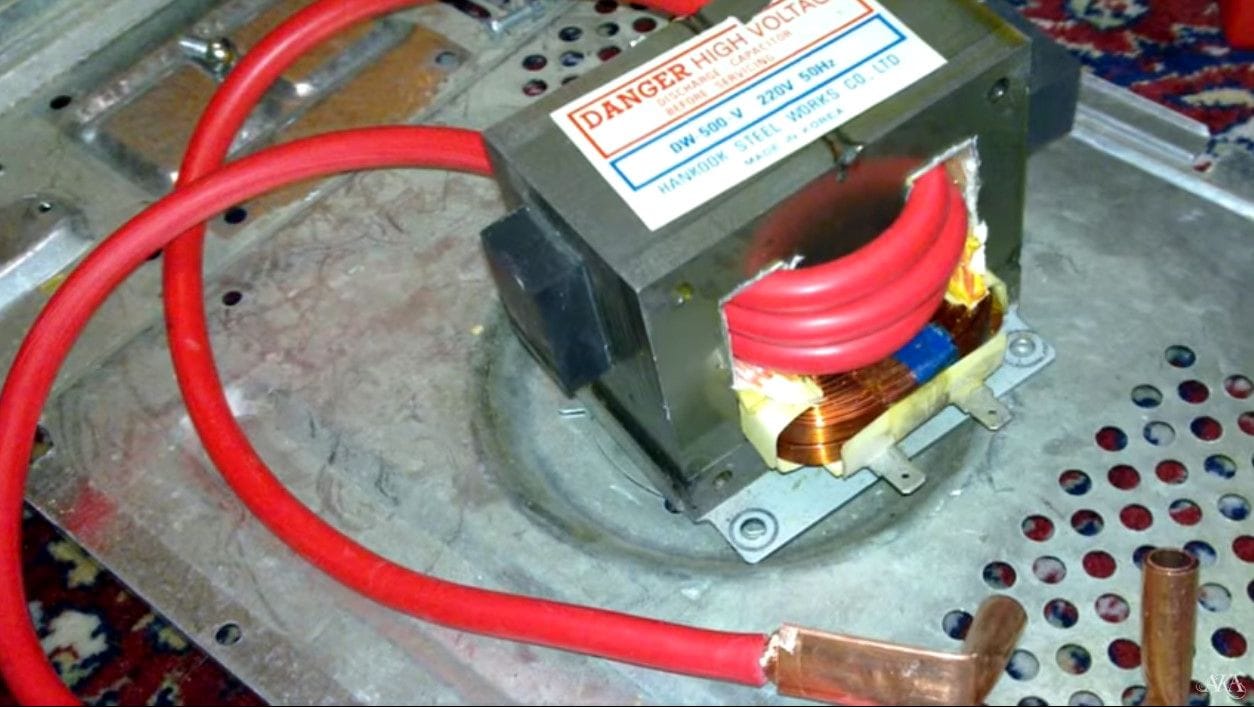

- Сердечник, для которого вполне подходит телевизор бывший в использовании.

- Плотная картонная бумага.

- Доски, а также бруски из природной древесины.

- Прут из стали.

- Пила, специальный клей.

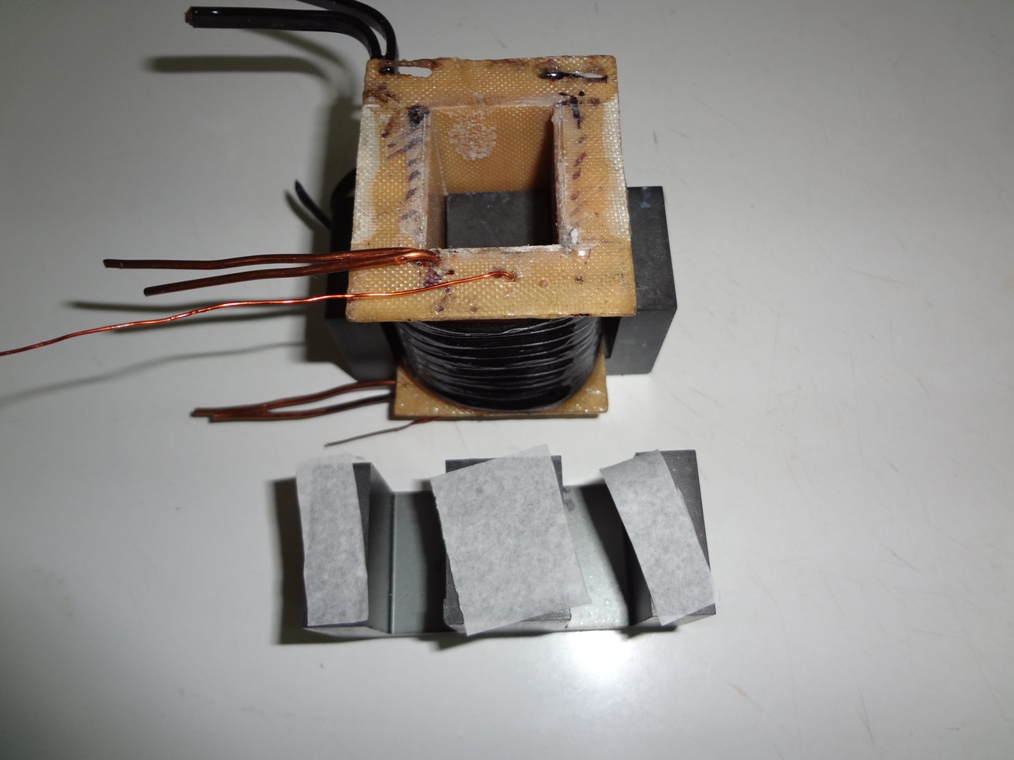

Сделать собственными руками трансформатор, как на фото, совершенно не проблематично. Если требуется изготовление трансформатора, предназначенного для лампочек галогенных, то вполне можно использовать тоже перечисленные выше инструменты.

Не забывайте, что очень важно придерживаться технологического процесса намотки. При точном соблюдении важных правил, аппарат прослужит вам ни одно десятилетие. Данных материалов, а также инструментов вам будет вполне достаточно для собственноручного создания качественного и практичного в применении трансформатора.

На основе подобной самоделки можно сформировать трансформатор для подзарядки машинного аккумулятора, либо создать повышающий прибор для источника питания лабораторного, выжигатель по древесине, либо другое устройство, которое удовлетворит нужды мастера по дому.

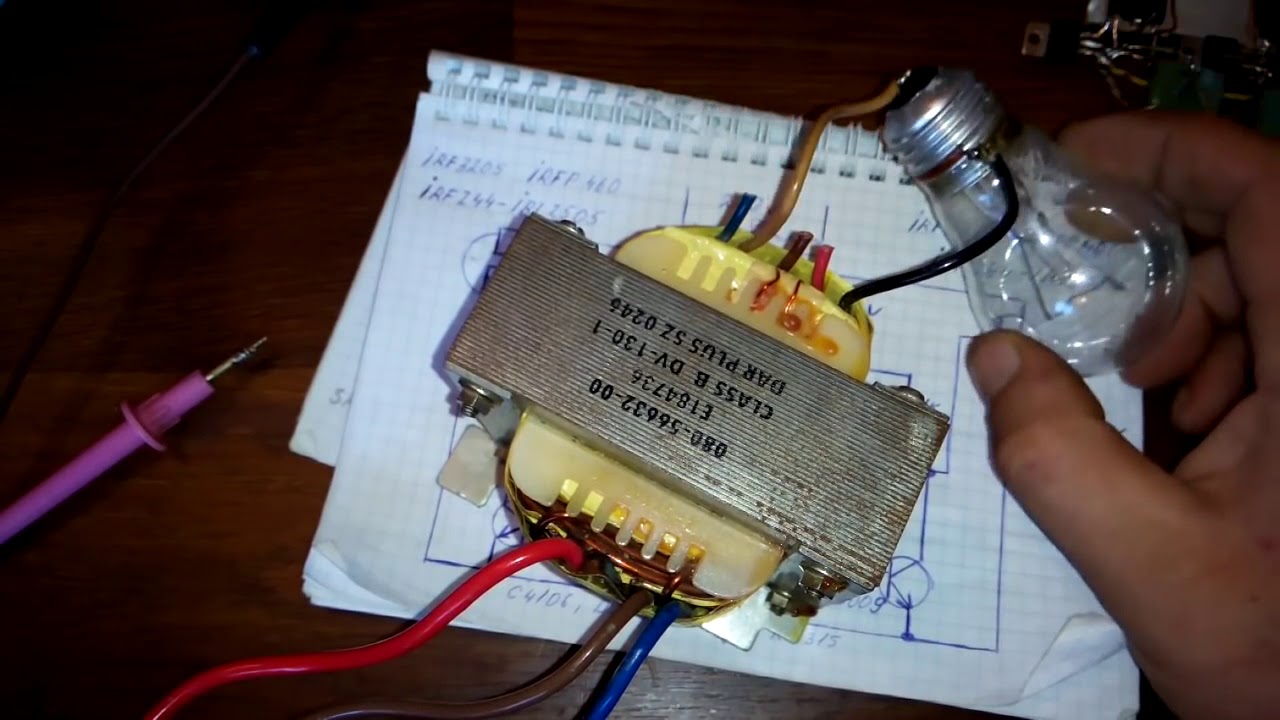

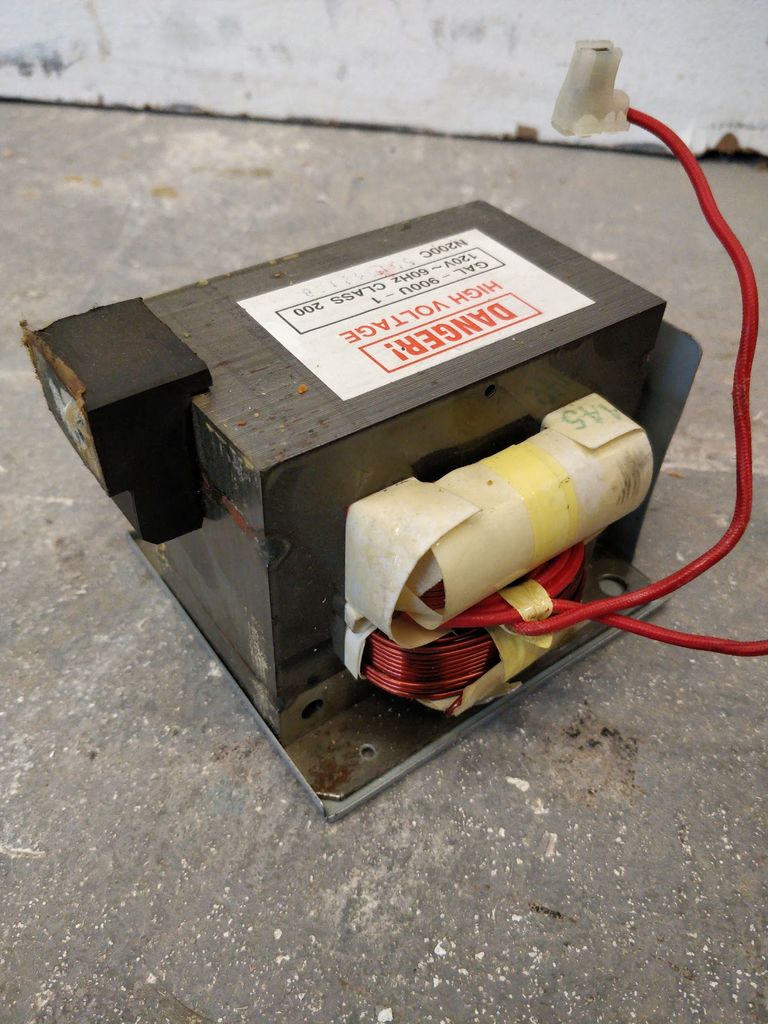

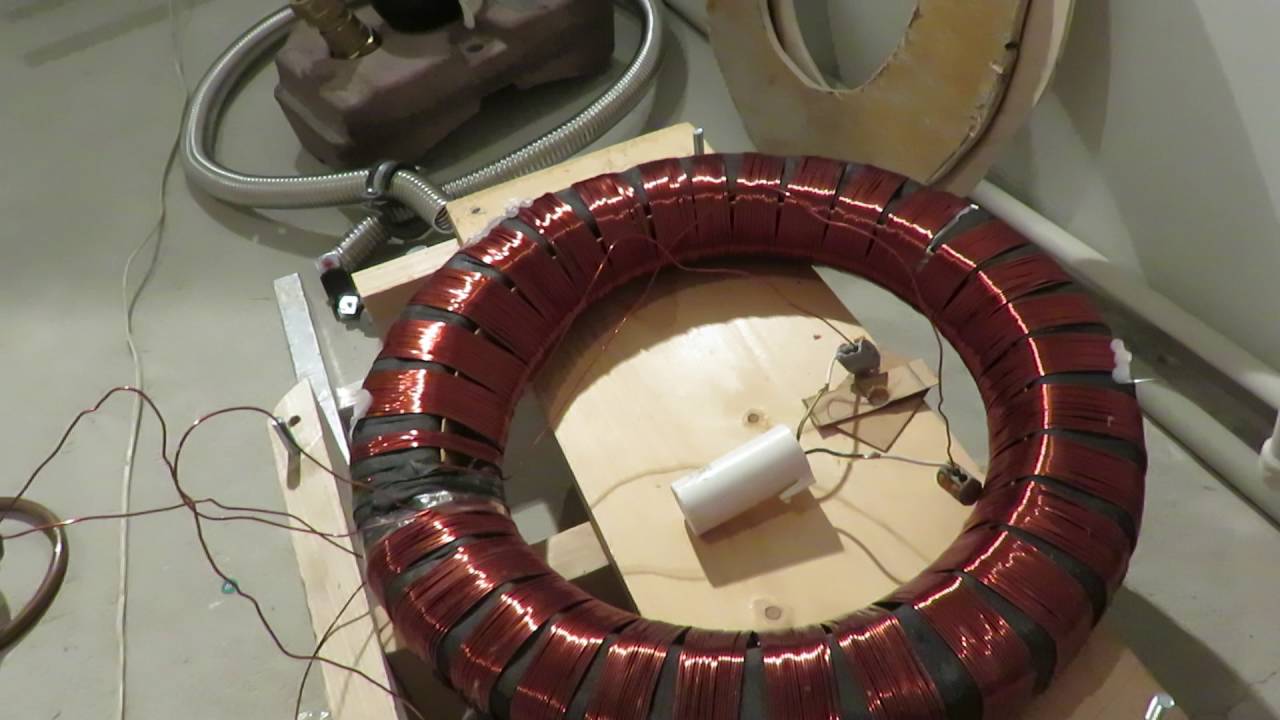

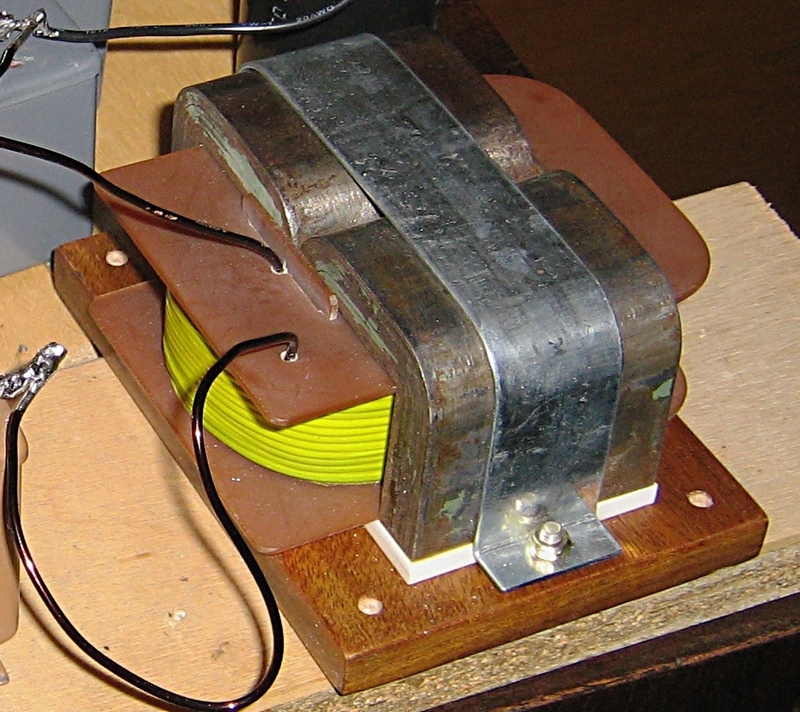

Фото трансформаторов своими руками

Трансформатор своими руками: инструкция + фото

Принцип действия трансформатора

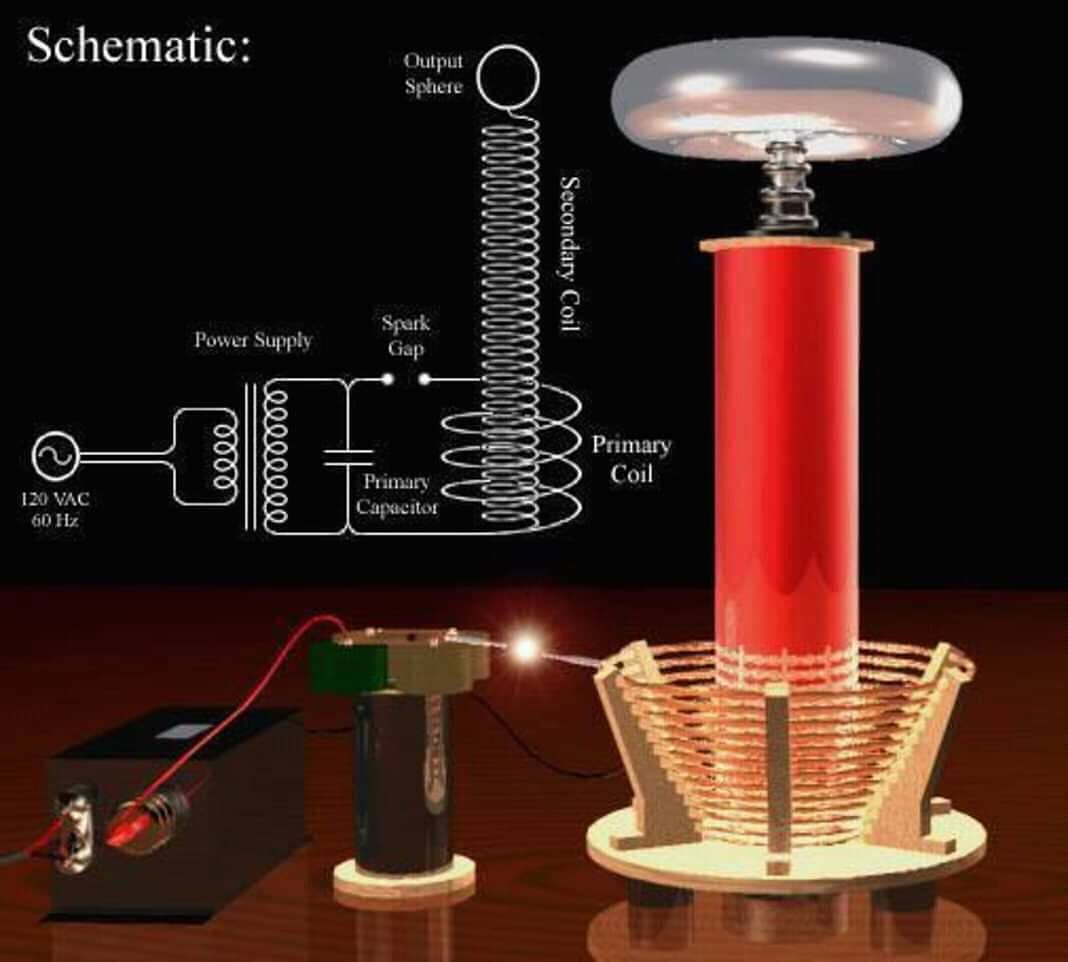

От устройства трансформатора перейдём к принципу его работы. Для этого рассмотрим трансформатор изображённый на рисунке ниже.

Данный трансформатор состоит из двух катушек (обмоток) I и II, находящихся на стержневом магнитопроводе. К катушке I подводится переменное напряжение u1; это катушка называется первичной обмоткой. На выводах катушки II, называемой вторичной обмоткой, формируется напряжение u2, которое передается приёмникам электрической энергии.

К катушке I подводится переменное напряжение u1; это катушка называется первичной обмоткой. На выводах катушки II, называемой вторичной обмоткой, формируется напряжение u2, которое передается приёмникам электрической энергии.

Работа трансформатора заключается в следующем. При протекании переменного тока i1 в первичной обмотке I создаётся магнитное поле, магнитный поток, которого пронизывает не только создавшую его обмотку (магнитный поток Ф1), но и частично вторичную обмотку (магнитный поток Ф). То есть обмотки трансформатора являются магнитно связанными, при этом степень связи зависит от взаимного расположения обмоток: чем дальше обмотки друг от друга, тем меньше магнитная связь между ними и меньше магнитный поток Ф.

Так как через первичную обмотку протекает переменный ток, то и создаваемый им магнитный поток непрерывно изменяет свою величину и свое направление. Согласно закону электромагнитной индукции, при изменении пронизывающего катушку магнитного потока, в катушке индуцируется переменная электродвижущая сила. Таким образом, в первичной обмотке индуцируется электродвижущая сила самоиндукции, а во вторичной обмотке – электродвижущая сила взаимноиндукции.

Таким образом, в первичной обмотке индуцируется электродвижущая сила самоиндукции, а во вторичной обмотке – электродвижущая сила взаимноиндукции.

Если присоединить концы вторичной обмотки к приемнику электрической энергии (нагрузке), то через неё потечёт ток i2. В тоже время в первичную обмотку будет поступать ток i1 от источника энергии (генератора). Таким образом энергия от первичной обмотки во вторичную будет передаваться при помощи переменного магнитного потока Ф.

На рисунке видно, что часть магнитного потока первичной Ф1 и вторичной Ф2 обмотки не замыкается через магнитопровод. Они не участвуют в передаче энергии, а образуют так называемое магнитное поле рассеяния.

Одной из задач проектирования трансформаторов является сведение магнитного потока рассеяния к минимуму.

Трансформатор тока

Кроме стандартного типа трансформаторов напряжения существует особый вид, называемый трансформатором тока. Основное его назначение — изменять значение тока относительно своего входа. Другое название такого вида устройства — токовый.

Другое название такого вида устройства — токовый.

Токовое устройство по виду ничем не отличается от трансформатора напряжения, его отличия — в подключении и количестве витков в обмотке. Первичка выполняется с помощью одного или пары витков. Эти витки пропускаются через тороидальный магнитопровод, и именно через них измеряется ток. Токовые устройства выполняются не только тороидального типа, но и могут быть выполнены и на других видах сердечниках. Главным условием является то, чтобы измеряемый провод совершил полный виток.

Вторичная обмотка при таком исполнении шунтируется низкоомным сопротивлением. При этом величина напряжения на этой обмотке не должна быть большого значения, так как во время прохождения наибольших токов сердечник будет находиться в режиме насыщения.

В некоторых случаях измерения проводятся на нескольких проводниках которые пропущены через тор. Тогда величина тока будет пропорциональна силе суммы токов.

Как изготовить самостоятельно

Понижающий трансформатор можно выполнить как отдельное устройство либо расположить в блоке питания техники. По сути, это радиоэлектронный элемент и его под силу смастерить своими руками.

Сначала стоит подготовить инструменты и материал, произвести предварительный расчет. Для работы потребуется:

- ленточная изоляция высокого качества;

- сердечник, снятый со старого телевизора;

- провода с эмалевой изоляцией;

- простой станок для намотки, например, из доски (ширина – 10 см, длина – 40 см).

Пошаговые действия:

- Изготовить каркас, вырезав из картона внутреннюю часть, немного большую в отличие от стержня сердечника. Если используется сердечник в виде буквы “О”, то потребуется 2 катушки. При сердечнике буквой “Ш” хватит одной катушки.

- На круглый сердечник предварительно намотать изоляцию в 3 слоя после первичной обмотки.

- Накрутить второй слой с и выведением наружу концов обмотки. Вторичная, равно как и первичная обмотка, прокладываются в идентичном направлении. Главное, не забывать выводить провода.

- Вставить железные полоски в готовую катушку, обогнуть ими каркас с одной стороны, соединить внизу. Оставить между каркасом и сердечником воздушный зазор.

- Сделать основание для трансформатора. На дощечку (толщина 5 см) прикрепить металлическими скобами 2 бруска (50х50 см) на расстоянии в 30 см друг от друга. Согнуть скобы так, чтобы огибали нижнюю часть сердечника.

- Вывести на каркас концы обмоток, прикрепить к контактам.

На каждый Вольт должно прийтись по 10 витков. Рассчитать их нужное количество несложно. Сердечник можно вынуть из ненужного трансформатора любого типа или изготовить из жести. Подойдет консервная банка, из которой вырезается 80 полосок в длину 30 см, ширину – 2 см от. Отжигаются полоски их в печи, остужаются, очищаются от окалины и покрываются лаком. Можно с одной стороны оклеить тонкой бумагой.

Можно с одной стороны оклеить тонкой бумагой.

Заметка! Все разметки и линии нельзя делать графитом.

Расчет конструкции производится по формуле P = U * I,. Из нее исчисляется мощность, которая выдержит вторичную обмотку.

Как организуется внеочередная проверка знаний?

Организует внеочередную проверку знаний:

- служба ОТ;

- непосредственный руководитель работ;

- инспектор ГИТ или другой проверяющий;

- специализированный центр по договору с компанией, сотрудники которой будут экзаменоваться. Нужно учитывать, что в центре можно проверять знания только тех сотрудников, которые там обучались. Например, по Положению 1/29 нельзя провести обучение силами предприятия, а на проверку знаний придти в специализированный центр.

Обучение по охране труда в специализированном центре имеет преимущество – в их комиссии по проверке знаний включаются представители надзорных органов. Поэтому к таким проверкам все готовятся особенно тщательно. Во время проверки состояния безопасности на предприятии удостоверение с подписью инспектора – дополнительный «+». В собственные комиссии предприятий их можно не включать – здесь достаточно руководителей и главных специалистов подразделений, специалистов по ОТ, представителей трудящихся. Минимальная численность комиссии – 3 человека. Включая должностных лиц в комиссию, нужно понимать сферу их деятельности и ответственности. Соответственно комплектуются группы. Например, включать в одну группу обучающихся грузчиков и электрослесарей нецелесообразно.

В собственные комиссии предприятий их можно не включать – здесь достаточно руководителей и главных специалистов подразделений, специалистов по ОТ, представителей трудящихся. Минимальная численность комиссии – 3 человека. Включая должностных лиц в комиссию, нужно понимать сферу их деятельности и ответственности. Соответственно комплектуются группы. Например, включать в одну группу обучающихся грузчиков и электрослесарей нецелесообразно.

Перед экзаменом трудящимся можно и нужно раздавать билеты, списки контрольных вопросов, чтобы они могли лучше подготовиться к экзамену и не тратить время на изучение ненужного материала. А вот ответы на билеты раздавать нельзя. Эту информацию трудящиеся должны получить во время обучения. Можно проводить пробные проверки знаний, если есть время. Главная ценность такой подготовки – возможность проработать ошибочные ответы, детально разъяснить неправильно понятые положения

Нужно обращать внимание, чтобы трудящиеся не только знали требования правил, инструкций и норм, но и четко понимали, как реализовать их на практике. В этом помогает моделирование ситуаций в аудитории или при помощи автоматизированных обучающих комплексов

В этом помогает моделирование ситуаций в аудитории или при помощи автоматизированных обучающих комплексов

Как будет проводиться проверка, какой материал будет проверяться, решает ее инициатор. Поэтому, когда во внеплановую проверку вовлекается большое количество трудящихся, а срок плановой проверки знаний уже близок, можно совместить 2 вида обучения. При этом все вопросы можно проверить в рамках 1 экзамена с заполнением соответствующей документации. Называть мероприятие лучше плановой проверкой, потому что проведение внеплановой проверки ее не отменяет. Чтобы отметить расширенный формат мероприятия, можно назвать его, например «расширенной плановой проверкой знаний».

Материал, по которому проводилась внеплановая проверка знаний, включается в программы последующих обучений и инструктажей. Соответственно, устаревшие нормы из них убираются. Внесенные изменения утверждаются приказом или распоряжением.

Поскольку оперативно корректировать периодичность проверки знаний по охране труда в крупных организациях – дело не одного дня, при вводе новых нормативных документов государство дает специалистам по обучению время на адаптацию учебных программ. Например, документ утверждается и выкладывается в общий доступ в январе, а вступает в силу только в июле. За это время можно успеть организовать обучение трудящихся и избежать нарушений. Возможен другой путь, как это было сделано в ФЗ о спецоценке условий труда – документ был утвержден и сразу же введен в действие, но чтобы перестроиться под требования его положений, компаниям был дан определенный срок.

Например, документ утверждается и выкладывается в общий доступ в январе, а вступает в силу только в июле. За это время можно успеть организовать обучение трудящихся и избежать нарушений. Возможен другой путь, как это было сделано в ФЗ о спецоценке условий труда – документ был утвержден и сразу же введен в действие, но чтобы перестроиться под требования его положений, компаниям был дан определенный срок.

Как повысить силу тока в цепи?

Бывают ситуации, когда требуется повысить I, который протекает в цепи, но при этом важно понимать, что нужно принять меры по защите электроприборов, сделать это можно с помощью специальных устройств. Рассмотрим, как повысить силу тока с помощью простых приборов

Рассмотрим, как повысить силу тока с помощью простых приборов.

Для выполнения работы потребуется амперметр.

По закону Ома ток равен напряжению (U), деленному на сопротивление (R). Простейший путь повышения силы I, который напрашивается сам собой — увеличение напряжения, которое подается на вход цепи, или же снижение сопротивления. При этом I будет увеличиваться прямо пропорционально U.

При этом I будет увеличиваться прямо пропорционально U.

К примеру, при подключении цепи в 20 Ом к источнику питания c U = 3 Вольта, величина тока будет равна 0,15 А.

Если добавить к цепи еще один источник питания на 3В, общую величину U удается повысить до 6 Вольт. Соответственно, ток также вырастет в два раза и достигнет предела в 0,3 Ампера.

Подключение источников питания должно осуществляться последовательно, то есть плюс одного элемента подключается к минусу первого.

Для получения требуемого напряжения достаточно соединить в одну группу несколько источников питания.

В быту источники постоянного U, объединенные в одну группу, называются батарейками.

Несмотря на очевидность формулы, практические результаты могут отличаться от теоретических расчетов, что связано с дополнительными факторами — нагревом проводника, его сечением, применяемым материалом и так далее.

В итоге R меняется в сторону увеличения, что приводит и к снижению силы I.

Повышение нагрузки в электрической цепи может стать причиной перегрева проводников, перегорания или даже пожара.

Вот почему важно быть внимательным при эксплуатации приборов и учитывать их мощность при выборе сечения. Величину I можно повысить и другим путем, уменьшив сопротивление

К примеру, если напряжение на входе равно 3 Вольта, а R 30 Ом, то по цепи проходит ток, равный 0,1 Ампер

Величину I можно повысить и другим путем, уменьшив сопротивление. К примеру, если напряжение на входе равно 3 Вольта, а R 30 Ом, то по цепи проходит ток, равный 0,1 Ампер.

Если уменьшить сопротивление до 15 Ом, сила тока, наоборот, возрастет в два раза и достигнет 0,2 Ампер. Нагрузка снижается почти к нулю при КЗ возле источника питания, в этом случае I возрастают до максимально возможной величины (с учетом мощности изделия).

Дополнительное снизить сопротивление можно путем охлаждения провода. Такой эффект сверхпроводимости давно известен и активно применяется на практике.

Чтобы повысить силу тока в цепи часто применяются электронные приборы, например, трансформаторы тока (как в сварочниках). Сила переменного I в этом случае возрастает при снижении частоты.

Если в цепи переменного тока имеется активное сопротивление, I увеличивается при росте емкости конденсатора и снижении индуктивности катушки.

В ситуации, когда нагрузка имеет чисто емкостной характер, сила тока возрастает при повышении частоты. Если же в цепь входят катушки индуктивности, сила I будет увеличиваться одновременно со снижением частоты.

Чтобы повысить силу тока, можно ориентироваться на еще одну формулу, которая выглядит следующим образом:

I = U*S/(ρ*l). Здесь нам неизвестно только три параметра:

- S — сечение провода;

- l — его длина;

- ρ — удельное электрическое сопротивление проводника.

Чтобы повысить ток, соберите цепочку, в которой будет источник тока, потребитель и провода.

Роль источника тока будет выполнять выпрямитель, позволяющий регулировать ЭДС.

Подключайте цепочку к источнику, а тестер к потребителю (предварительно настройте прибор на измерение силы тока). Повышайте ЭДС и контролируйте показатели на приборе.

Как отмечалось выше, при росте U удается повысить и ток. Аналогичный эксперимент можно сделать и для сопротивления.

Для этого выясните, из какого материала сделаны провода и установите изделия, имеющие меньшее удельное сопротивление. Если найти другие проводники не удается, укоротите те, что уже установлены.

Еще один путь — увеличение поперечного сечения, для чего параллельно установленным проводам стоит смонтировать аналогичные проводники. В этом случае возрастает площадь сечения провода и увеличивается ток.

Если же укоротить проводники, интересующий нас параметр (I) возрастет. При желании варианты увеличения силы тока разрешается комбинировать. Например, если на 50% укоротить проводники в цепи, а U поднять на 300%, то сила I возрастет в 9 раз.

Выбор инструментов

Чтобы сделать намотку для трансформатора максимально правильно, следует приобрести нужные для работы приспособления:

Часто для подобных целей применяют колодку из натурального массива, в которой делают отверстие для необходимой оси, а также подгоняют под требуемые каркасные размеры. Легче сделать всё это посредством дрели.

Её следует укрепить таким образом, чтобы размещение было параллельно настольной поверхности, в патрон вставляется непосредственно прут, на который заблаговременно нужно надеть колодку с трансформаторным каркасом. Желательно выбрать прут, который имеет резьбу. В данном варианте колодка просто фиксируется посредством гаек.

Также к элементу, без которого невозможно составить схему для собственноручного создания трансформатора, считается приспособление для размотки. Как правило, подобного типа устройства функционируют, как и приспособления для размотки, разница состоит в том, что в этом варианте можно не использовать ручку вращения.

Чтобы определиться с количеством требуемых витков, потребуется специальный прибор, к примеру, водяной счётчик. Для бесперебойной работы прибора необходимо соединить его со станком наматывающего типа посредством гибкого валика. При отсутствии данного приспособления можно подсчитать витки в уме.

Принцип функционирования

Провод, а также катушку необходимо закрепить в приборе намотке, при этом основу прибора – в приспособлении намотки. Следует проводить спокойные без срывов движения. Опустить провод на каркасную часть.

Между поверхностью, а также проводом должно оставаться 20 сантиметров, чтобы разместить руку на столе для удержания провода. Помимо этого на настольной поверхности должны располагаться дополнительные материалы, без которых невозможно создать собственными руками повышающий трансформатор.

Правой рукой нужно умеренно вращать устройство для намотки, а другой – держать провод

Важно ровная укладка провода. Далее нужно провести изоляцию каркаса, при этом имеющийся на проводе конец следует продеть через отверстие, чтобы быть зафиксированным в области оси прибора намотки.

Начало намотки следует проводить не спеша, максимально аккуратно: важно уметь навыки, чтобы обороты ложились максимально ровно.

Установить счётный прибор на ноль. Склеить изолирующий элемент, либо плотно прижать резиновым кольцом

Все обороты важно делать на пару витков уже в сравнении с предыдущими.

Конструкция и схема трансформатора тока

Обычно трансформаторы тока и амперметры используются вместе как согласованная пара, в которой конструкция трансформатора тока такова, чтобы обеспечить максимальный вторичный ток, соответствующий полномасштабному отклонению амперметра. В большинстве трансформаторов тока существует приблизительное соотношение обратных витков между двумя токами в первичной и вторичной обмотках. Вот почему калибровка трансформатора тока обычно для определенного типа амперметра.

Большинство трансформаторов тока имеют стандартную вторичную номинальную мощность 5 А, при этом первичные и вторичные токи выражаются в таком соотношении, как 100/5. Это означает, что ток первичной обмотки в 20 раз больше, чем ток вторичной обмотки, поэтому, когда в первичном проводнике протекает 100 ампер, во вторичной обмотке будет протекать 5 ампер. Трансформатор тока, скажем, 500/5, будет производить 5 А во вторичной обмотке при 500 А в первичной обмотке, что в 100 раз больше.

Увеличивая количество вторичных обмоток Ns, ток вторичной обмотки можно сделать намного меньшим, чем ток в измеряемой первичной цепи, потому что, когда Ns увеличивается, Is уменьшается пропорционально. Другими словами, число витков и ток в первичной и вторичной обмотках связаны обратно пропорционально.

Трансформатор тока, как и любой другой трансформатор, должен удовлетворять уравнению ампер-виток, и мы знаем из нашего учебника по трансформаторам напряжения с двойной обмоткой, что это отношение витков равно:

из которого мы получаем:

Коэффициент тока устанавливает коэффициент витков, и, поскольку первичный обычно состоит из одного или двух витков, тогда как вторичный может иметь несколько сотен витков, соотношение между первичным и вторичным может быть довольно большим. Например, предположим, что номинальный ток первичной обмотки составляет 100А. Вторичная обмотка имеет стандартный рейтинг 5А. Тогда соотношение между первичным и вторичным токами составляет 100А-5А или 20: 1. Другими словами, первичный ток в 20 раз больше вторичного тока.

Однако следует отметить, что трансформатор тока с номиналом 100/5 не совпадает с трансформатором с номиналом 20/1 или подразделениями 100/5. Это связано с тем, что отношение 100/5 выражает «номинальный ток на входе / выходе», а не фактическое соотношение первичных и вторичных токов. Также обратите внимание, что число витков и ток в первичной и вторичной обмотках связаны обратно пропорционально. Но относительно большие изменения в соотношении витков трансформаторов тока могут быть достигнуты путем изменения первичных витков через окно трансформатора ток, где один первичный виток равен одному проходу, а более одного прохода через окно приводит к изменению электрического соотношения

Но относительно большие изменения в соотношении витков трансформаторов тока могут быть достигнуты путем изменения первичных витков через окно трансформатора ток, где один первичный виток равен одному проходу, а более одного прохода через окно приводит к изменению электрического соотношения.

Так, например, трансформатор тока с отношением, скажем, 300 / 5А можно преобразовать в другой из 150 / 5А или даже 100 / 5А, пропустив основной первичный проводник через его внутреннее окно два или три раза, как показано ниже. Это позволяет более высокому значению трансформатора тока обеспечивать максимальный выходной ток для амперметра, когда используется на меньших первичных линиях тока.

Ссылки по теме

- Правила технической эксплуатации электроустановок потребителей

/ Нормативный документ от 9 февраля 2007 г. в 02:14 - Библия электрика

/ Нормативный документ от 14 января 2014 г. в 12:32 - Справочник по электрическим сетям 0,4-35 кВ и 110-1150 кВ. Том 10

/ Нормативный документ от 2 марта 2009 г. в 18:12 - Кабышев А.В., Тарасов Е.В. Низковольтные автоматические выключатели

/ Нормативный документ от 1 октября 2019 г. в 09:22 - Правила устройства воздушных линий электропередачи напряжением до 1 кВ с самонесущими изолированными проводами

/ Нормативный документ от 30 апреля 2008 г. в 15:00 - Маньков В.Д. Заграничный С.Ф. Защитное заземление и зануление электроустановок

/ Нормативный документ от 27 марта 2020 г. в 09:05 - Князевский Б.А. Трунковский Л.Е. Монтаж и эксплуатация промышленных электроустановок

/ Нормативный документ от 17 октября 2019 г. в 12:36

Монтаж составных частей, требующих разгерметизации бака трансформатора

После выполнения подготовительных работ трансформатор подается по рельсовому пути либо в мастерскую ТМХ, либо в машзал на фундамент или монтажную крестовину.

Монтаж составных частей силового трансформатора ведут без ревизии активной части и подъема «колокола», если не было нарушений условий транспортировки, выгрузки с повреждениями внутри бака трансформатора и хранения их.

Разгерметизацию силового трансформатора для установки составных частей (вводов, цилиндров, ТТ) следует производить в ясную сухую погоду. До этого следует подготовить рабочее место: установить подмости, стеллажи, ограждения. При разгерметизации принимаются меры к предохранению изоляции от увлажнения в процессе монтажа.

Очень эффективным устройством, значительно замедляющим процесс увлажнения изоляции при разгерметизации, является установка осушки воздуха «Суховей». Установка «Суховей» служит для глубокой осушки и очистки от механических примесей воздуха, используемого для подачи в бак трансформатора при его вскрытии, и производстве ревизии активной части. Опыт применения такой установки показывает, что воздух, прошедший через установку «Суховей», во много раз меньше увлажняет твердую изоляцию активной части трансформатора

Время разгерметизации в этом случае может быть значительно увеличено, но при этом не должно превышать 100 ч, а допустимое время разгерметизации больших люков под трансформаторы тока и вводы – 3 ч на каждый.

Работы во время разгерметизации силового трансформатора следует вести по разработанному часовому графику и выполнять с большой осторожностью и аккуратностью во избежание загрязнения внутреннего объема бака и падения внутрь инструментов и посторонних предметов. Монтаж составных частей силового трансформатора производят в следующем порядке

Удаляют из бака бакелитовые цилиндры вводов и крепеж к ним. Снимают транспортные детали и детали крепления отводов Проводят внешний осмотр креплений активной части и состояния механизма и контактов устройства РПН. Устанавливают патрубки вводов, встроенные ТТ. При установке вводов 110 кВ силовых трансформаторов мощностью до 100 МВА масло сливать не требуется.

Для установки ввод следует застропить, поднять, произвести центровку над патрубком, опустить, закрепить его и присоединить токоведущий стержень к отводу обмотки

При монтаже герметичных вводов перед установкой необходимо проверить и отрегулировать давление масла во вводе, обратить особое внимание на правильное размещение и установку соединительных трубок, а также контрольных манометров.

При монтаже наклонных вводов строповка, подъем и установка вводов выполняются с помощью специальной траверсы, полиспаста или талрепов.

После окончания монтажа внутренних частей остатки трансформаторного масла сливают (у трансформаторов, транспортируемых без масла) через донную пробку и герметизируют бак для последующего вакуумирования и заливки или доливки масла в трансформатор

Типы устройств

В зависимости от мощности, конструкции и сферы их применения, существуют такие виды трансформаторов:

- Автотрансформатор конструктивно выполнен как одна обмотка с двумя концевыми клеммами, а также в промежуточных точках устройства имеются несколько терминалов, в которых располагаются первичные и вторичные катушки.

- Трансформатор тока включает в себя первичную и вторичную обмотку, сердечник из магнитного материала, а также оптические датчики, специальные резисторы, позволяющие ускорять способы регулировки напряжения.

- Силовой трансформатор — это устройство, передающее ток, при помощи индукции электромагнитного поля, между двумя контурами. Такие трансформаторы могут быть повышающими или понижающими, сухими или масляными.

- Антирезонансные трансформаторы могут быть как однофазными, так и трёхфазными. Принцип работы такого устройства мало чем отличается от трансформаторов силового типа. Конструктивно представляет собой устройство литого типа с хорошей теплозащитой и полузакрытой структурой. Трансформаторы антирезонансного типа применяются при передаче сигнала на большие расстояния и в условиях больших нагрузок. Идеально подходят для работы в любых климатических условиях.

- Заземляемые трансформаторы (догрузочные). Особенностью этого типа является расположение обмоток в форме звезды или зигзага. Часто заземляемые приборы применяют для подключения счётчика электрической энергии.

- Пик — трансформаторы используются в устройствах радиосвязи и технологиях компьютерного производства, по принципу отделения постоянного и переменного тока. Конструкция такого трансформатора является упрощённой: обмотка с определённым количеством витков расположена вокруг сердечника из ферромагнитного материала.

- Разделительный домашний трансформатор применяется при передаче энергии переменного тока к другому устройству или оборудованию, блокируя при этом способности источника энергии. В бытовых условиях такие приборы обеспечивают регулирование напряжения и гальваническую развязку. Чаще всего применяются для подавления электрических помех в чувствительных приборах и защиты от вредного воздействия электрического тока.

Сборка повышающего трансформатора

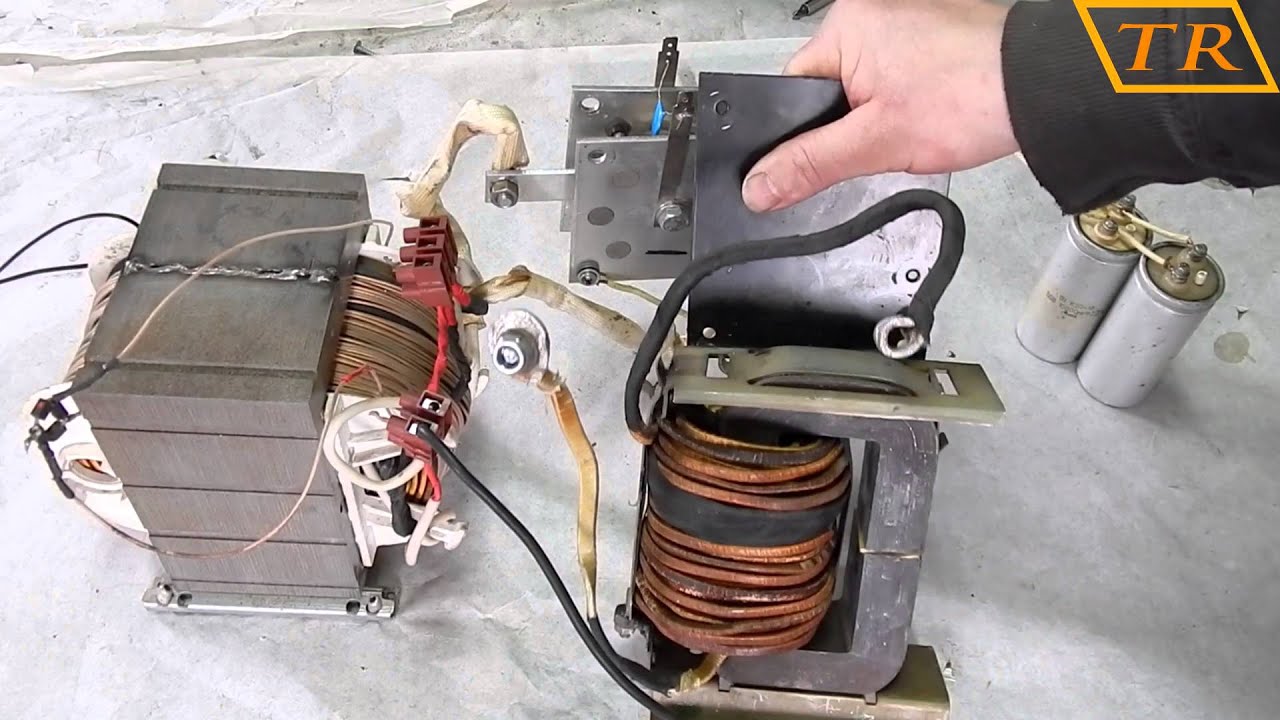

Разбирают сердечник. Так как использован О-образный его тип из трансформаторного железа от телевизора, то это легко сделать, так как он состоит из двух половин. Надевают на «рога» обе катушки и соединяют обе части аппарата, зажимают крепежные детали.

Схема устройства однофазного трансформатора.

При использовании отдельных пластин для сборки вначале по мощности трансформатора определяют толщину его пакета и, соответственно, нужное число Ш-образных или О-образных листов (по справочнику). Затем их поочередно вставляют в отверстие на гильзе катушки и стягивают шпильками и гайками (в пластинах есть для этого специальные отверстия).

Если при включении трансформатора слышен шум или дребезг, то надо поплотнее закрутить крепеж. Это делают до тех пор, пока «жужжание» не прекратится. Производят испытание: включают трансформатор в сеть вторичной обмоткой – на первичной стороне должно появиться напряжение 12 В.

Если это условие выполнено, то трансформатор собран правильно.

Расчетная часть

Итак, начнем. Для начала необходимо разобраться, что представляет из себя такое устройство. Трансформатор состоит из двух или более электрических катушек (первичной и вторичной) и металлического сердечника, выполненного из отдельных железных пластин. Первичная обмотка создает магнитный поток в магнитопроводе, а тот в свою очередь индуцирует электрический ток во второй катушке, что показано на схеме ниже. Исходя из соотношения числа витков в первичной и вторичной катушки, трансформатор либо повышает, либо понижает напряжение, пропорционально ему меняется и ток.

От размеров сердечника зависит максимальная мощность, которую трансформатор сможет отдать, поэтому при проектировании отталкиваются от наличия подходящего сердечника. Расчет всех параметров начинается с определения габаритной мощности трансформатора и подключаемой к нему нагрузки. Поэтому сначала нам необходимо найти мощность вторичной цепи. Если вторичная катушка не одна, то их мощность нужно суммировать. Расчетная формула будет иметь вид:

P2=U2*I2

Где:

- U2 — это напряжение на вторичной обмотке;

- I2 — ток вторичной обмотки.

Получив значение, нужно сделать расчет первичной обмотки, учитывая потери на трансформации, предполагаемый КПД около 80%.

P1=P2/0.8=1.25*P2

От значения мощности Р1 подбирается сердечник, его площадь сечения S.

S=√Р1

Где:

- S в сантиметрах;

- Р1 в ватт.

Теперь мы можем узнать коэффициент эффективной передачи и трансформации энергии:

w’=50/S

Где:

- 50 — это частота сети;

- S — сечение железа.

Эта формула дает приблизительное значение, но для простоты расчета вполне подойдет, так как мы изготавливаем деталь в домашних условиях. Далее можно приступить к расчету количества витков, сделать это можно по формуле:

w1=w’*U1

w2=w’*U2

w3=w’*U3

Так как расчет у нас упрощенный и возможна небольшая просадка напряжения под нагрузкой, увеличьте число витков на 10 % от расчетного значения. Далее нужно правильно определить ток наших обмоток, сделать это нужно для каждой обмотки в отдельности по этой формуле:

I1=P1/U1

Определяем диаметр необходимого провода по формуле:

d = 0.8*√I

Исходя из таблицы 1 выбираем провод с искомым сечением. Если подходящего значения нет, нужно сделать округление в большую сторону до табличного диаметра.

Если посчитанного диаметра нет в таблице, или слишком большое заполнение окна получается, то можно взять несколько проводов меньшего сечения и получить в сумме искомое.

Чтобы узнать поместятся ли катушки на нашем самодельном трансформаторе, требуется посчитать площадь окна тр-ра, это образованное сердечником пространство, в которое помещаются катушки. Уже известное число витков умножаем на сечение провода и коэффициент заполнения:

s= w*d²*0.8

Данный расчет производим для всех обмоток, первичной и вторичной, после чего нужно суммировать площадь катушек и сделать сравнение с площадью окна магнитопровода. Окно сердечника должно быть больше площади сечения катушек.

Оцените статью:Как сделать тороидальный трансформатор своими руками

На сегодняшний день многие домашние электрики задумываются о том, как сделать тороидальный трансформатор. Этот спрос на него обеспечен тем, что он имеет сердечник, который значительно лучше по сравнению с другими. Он имеет меньший вес, который может отличаться в полтора раза. Также и КПД этого трансформатора будет значительно выше.

Вот основные причины, которые останавливают многих мастеров при его изготовлении:

- Достаточно сложно найти подходящий сердечник.

- Его изготовление занимает много времени.

Тороидальный трансформатор и его расчет

Для того чтобы значительно облегчить расчет тороидального трансформатора вам необходимо знать следующие данные:

- Выходное напряжение, которое будет подаваться на первичную обмотку U.

- Диаметр сердечника внешний D.

- Внутренний диаметр сердечника d.

- Магнитопровод

Sc = H * (D – d)/2.

Наиболее важной характеристикой сердечника считается площадь его окна S. Этот параметр будет определять интенсивность отвода избытков тепла. Оптимальное значение этого параметра может составлять 80-100 см. Вычисляется он по формуле:

S0 = π * d2 / 4.

Благодаря этим значениям вы легко рассчитаете его мощность по формуле:

P = 1,9 * Sc * S0, где Sc и S0 необходимо брать в квадратных сантиметрах, а P получится в ваттах. Затем вам потребуется найти число витков на один вольт:

k = 50 / Sc.

Когда значение k вам станет известным, то можно будет рассчитать количество витков во вторичной обмотке:

w2 = U2 * k.

Производить расчеты лучше, если в качестве исходного значения использовать напряжение на вторичной обмотке:

W1 = (U1 * w2) / U2, где U1 – это напряжение, которое подводят к первичной обмотке, а U2 снимаемое со вторичной.

Сварочный ток проще всего регулировать с помощью изменения числа витков в первичной обмотке, так как здесь существует меньшое напряжение.

Изготовление тороидального сердечника

Тороидальные трансформаторы содержат в своей конструкции сложный сердечник. Лучшим материалом для его изготовления считается трансформаторная сталь. Для того чтобы изготовить сердечник тороидального трансформатора вам необходимо использовать стальную ленту. Ее необходимо свернуть в рулон, который будет иметь форму Тора. Если у вас уже есть такая форма, то никаких проблем возникнуть не должно.

Хороший готовый сердечник вы также можете найти на лабораторном автотрансформаторе. Вам следует перемотать его обмотки. Измерительные трансформаторы имеют более простой сердечник.

Еще к одному способу изготовления тороидального сердечника относят использование пластин от неисправного промышленного трансформатора. Сначала из этих закрепок вам потребуется изготовить обруч. Его диаметр должен составлять 26 см. Внутрь этого обруча необходимо постепенно вставлять пластины. Следите за тем чтобы они не разматывались.

Намотка тороидального трансформатора

Намотка тороидального трансформатора – это достаточно сложный процесс, который занимает много времени. Тороидальный трансформатор имеет одну из наиболее сложных намоток. Наиболее простым способом считается использование специального челнока. На него следует намотать провод нужной длины и затем его через отверстия. Он имеет сложную конструкцию, но это не влияет на принцип работы трансформатора тороидального. После пропуска через челнок у вас начнет формироваться соответствующая обмотка.

Надеемся, что благодаря этой статье вы самостоятельно сможете изготовить тороидальный трансформатор своими руками.

как сделать трансформатор Тесла своими руками?

трансформатор +своими руками | Электрознайка. Домашний Электромастер.

В домашнем хозяйстве бывает необходимо оборудовать освещение в сырых помещениях: подвале или погребе и т.д. Эти помещения имеют повышенную степень опасности поражения электичческим током.

В этих случаях следует пользоваться электрооборудованием рассчитанным на пониженное напряжение питания, не более 42 вольт.

Можно пользоваться электрическим фонарем с батарейным питанием или воспользоваться понижающим трансформатором с 220 вольт на 36 вольт.

Рассчитаем и изготовим однофазный силовой трансформатор 220/36 вольт, с выходным напряжением 36 вольт с питанием от электрической сети переменного тока напряжением 220 вольт.

Для освещения таких помещений подойдет электрическая лампочка на 36 Вольт и мощностью 25 — 60 Ватт. Такие лампочки с цоколем под обыкновенный электропатрон продаются в магазинах электротоваров.

Если вы найдете лампочку на другую мощнось, например на 40 ватт, нет ничего страшного — подойдет и она. Просто трансформатор будет выполнен с запасом по мощности.

Мощность во вторичной цепи: Р_2 = U_2 · I_2 = 60 ватт

Где:

Р_2 – мощность на выходе трансформатора, нами задана 60 ватт;

U_2 — напряжение на выходе трансформатора, нами задано 36 вольт;

I_2 — ток во вторичной цепи, в нагрузке.

КПД трансформатора мощностью до 100 ватт обычно равно не более η = 0,8.

КПД определяет, какая часть мощности потребляемой от сети идет в нагрузку. Оставшаяся часть идет на нагрев проводов и сердечника. Эта мощность безвозвратно теряется.

Определим мощность потребляемую трансформатором от сети с учетом потерь:

Р_1 = Р_2 / η = 60 / 0,8 = 75 ватт.

Мощность передается из первичной обмотки во вторичную через магнитный поток в магнитопроводе. Поэтому от значения Р_1, мощности потребляемой от сети 220 вольт, зависит площадь поперечного сечения магнитопровода S.

Магнитопровод – это сердечник Ш – образной или О – образной формы, набранный из листов трансформаторной стали. На сердечнике будут располагаться первичная и вторичная обмотки провода.

Площадь поперечного сечения магнитопровода рассчитывается по формуле:

S = 1,2 · √P_1.

Где:

S — площадь в квадратных сантиметрах,

P_1 — мощность первичной сети в ваттах.

S = 1,2 · √75 = 1,2 · 8,66 = 10,4 см².

По значению S определяется число витков w на один вольт по формуле:

w = 50/S

В нашем случае площадь сечения сердечника равна S = 10,4 см.кв.

w = 50/10,4 = 4,8 витка на 1 вольт.

Рассчитаем число витков в первичной и вторичной обмотках.

Число витков в первичной обмотке на 220 вольт:

W1 = U_1 · w = 220 · 4.8 = 1056 витка.

Число витков во вторичной обмотке на 36 вольт:

W2 = U_2 · w = 36 · 4,8 = 172.8 витков,

округляем до 173 витка.

В режиме нагрузки может быть заметная потеря части напряжения на активном сопротивлении провода вторичной обмотки. Поэтому для них рекомендуется число витков брать на 5-10 % больше рассчитанного. Возьмем W2 = 180 витков.

Величина тока в первичной обмотке трансформатора:

I_1 = P_1/U_1 = 75/220 = 0,34 ампера.

Ток во вторичной обмотке трансформатора:

I_2 = P_2/U_2 = 60/36 = 1,67 ампера.

Диаметры проводов первичной и вторичной обмоток определяются по значениям токов в них исходя из допустимой плотности тока, количества ампер на 1 квадратный миллиметр площади проводника. Для трансформаторов плотность тока, для медного провода, принимается 2 А/мм² .

При такой плотности тока диаметр провода без изоляции в миллиметрах определяется по формуле: d = 0,8√I .

Для первичной обмотки диаметр провода будет:

d_1 = 0,8 · √1_1 = 0,8 · √0,34 = 0,8 · 0,58 = 0,46 мм. Возьмем 0,5 мм.

Диаметр провода для вторичной обмотки:

d_2 = 0,8 · √1_2 = 0,8 · √1,67 = 0,8 · 1,3 = 1,04 мм. Возьмем 1,1 мм.

ЕСЛИ НЕТ ПРОВОДА НУЖНОГО ДИАМЕТРА, то можно взять несколько, соединенных параллельно, более тонких проводов. Их суммарная площадь сечения должна быть не менее той, которая соответствует рассчитанному одному проводу.

Площадь поперечного сечения провода определяется по формуле:

s = 0,8 · d².

где: d — диаметр провода.

Например: мы не смогли найти провод для вторичной обмотки диаметром 1,1 мм.

Площадь поперечного сечения провода диаметром 1,1 мм. равна:

s = 0,8 · d² = 0,8 · 1,1² = 0,8 · 1,21 = 0,97 мм².

Округлим до 1,0 мм².

Из таблицы выбираем диаметры двух проводов сумма площадей сечения которых равна 1.0 мм².

Например, это два провода диаметром по 0,8 мм. и площадью по 0,5 мм².

Или два провода:

— первый диаметром 1,0 мм. и площадью сечения 0,79 мм²,

— второй диаметром 0,5 мм. и площадью сечения 0,196 мм².

что в сумме дает: 0,79 + 0,196 = 0,986 мм².

Намотка катушки ведется двумя проводами одновременно, строго выдерживается равное количество витков обоих проводов. Начала этих проводов соединяются между собой. Концы этих проводов также соединяются.

Получается как бы один провод с суммарным поперечным сечением двух проводов.

Смотрите статьи:— «Как намотать трансформатор на Ш-образном сердечнике».

— «Как изготовить каркас для Ш — образного сердечника».

Как рассчитать и намотать трансформатор своими руками? FAQ

Как рассчитать и намотать силовой низкочастотный трансформатор для блока питания УНЧ? FAQ Часть 1

Эта тема возникла в связи с написанием статьи о самодельном усилителе низкой частоты. Хотел продолжить повествование, рассказав о блоке питания и добавив ссылку на какую-нибудь популярную статью о перемотке трансформаторов, но не нашёл простого понятного описания. Что ж поделаешь, всё нужно делать самому. https://oldoctober.com/

В этом опусе я расскажу, на примере своей конструкции, как рассчитать и намотать силовой трансформатор для УНЧ. Все расчёты сделаны по упрощённой методике, так как в подавляющем большинстве случаев, радиолюбители используют уже готовые трансформаторы. Статья рассчитана на начинающих радиолюбителей.

Самые интересные ролики на Youtube

Те же, кто хочет углубиться в расчёты, может скачать очень хорошую книжку с примерами полного расчёта трансформатора, ссылка на которую есть в конце статьи. Также в конце статьи есть ссылка на несколько программ для расчёта трансформаторов.

Близкие темы.

Блок питания для усилителя низкой частоты из доступных деталей. УНЧ, часть 3.

Как подружить Блокнот с Калькулятором Windows, чтобы облегчить расчёты?

Оглавление статьи.

- Как определить необходимую мощность силового трансформатора для питания УНЧ?

- Какую схему питания УНЧ выбрать?

- Расчёт выходного напряжения (переменного тока) трансформатора работающего на холостом ходу или без существенной нагрузки.

- Расчёт напряжения (постоянного тока) на выходе блока питания работающего при максимальной нагрузке.

- Типы магнитопроводов силовых трансформаторов.

- Как определить габаритную мощность трансформатора?

- Где взять исходный трансформатор?

- Как подключить неизвестный трансформатор к сети?

- Как сфазировать обмотки трансформатора?

- Как определить количество витков вторичной обмотки?

- Как рассчитать диаметр провода для любой обмотки?

- Как измерить диаметр провода?

- Как рассчитать количество витков первичной обмотки?

- Как разобрать и собрать трансформатор?

- Как намотать трансформатор?

- Как закрепить выводы обмоток трансформатора?

- Как изменить напряжение на вторичной обмотке не разбирая трансформатор?

- Программы для расчёта силовых трансформаторов.

- Дополнительные материалы к статье.

Страницы 1 2 3 4

Как определить необходимую мощность силового трансформатора для питания УНЧ?

Для колонок описанных здесь, я решил собрать простой усилитель мощностью 8-10 Ватт в канале, на самых дешёвых микросхемах, которые только удалось найти на местном радиорынке. Ими оказались – TDA2030 ценой всего по 0,38$.

Предполагаемая мощность в нагрузке должна составить 8-10 Ватт в канале:

10 * 2 = 20W

КПД микросхемы TDA2030 по даташиту (datasheet) – 65%.

20 / 0,65 = 31W

Я подобрал трансформатор с витым броневым магнитопроводом, так что, КПД можно принять равным – 90%.https://oldoctober.com/

31 / 0,9 = 34W

Приблизительно оценить КПД трансформатора можно по таблице.

| Мощность трансформатора (Вт) | КПД трансформатора (%) | |||

| Броневой штампованный | Броневой витой | Стержневой витой | Кольцевой | |

| 5-10 | 60 | 65 | 65 | 70 |

| 10-50 | 80 | 90 | 90 | 90 |

| 50-150 | 85 | 93 | 93 | 95 |

| 150-300 | 90 | 95 | 95 | 96 |

| 300-1000 | 95 | 96 | 96 | 96 |

Значит, понадобится сетевой трансформатор мощностью около 30-40 Ватт. Такой трансформатор должен весить около килограмма или чуть больше, что, на мой взгляд, прибавит моему мини усилителю устойчивости и он не будет «бегать» за шнурами.

Если мощность трансформатора больше требуемой, то это всегда хорошо. У более мощных трансформаторов выше КПД. Например, трансформатор мощностью 3-5 Ватт может иметь КПД всего 50%, в то время как у трансформаторов мощностью 50–100 Ватт КПД обычно около 90%.

Итак, с мощностью трансформатора вроде всё более или менее ясно.

Теперь нужно определиться с выходным напряжением трансформатора.

Вернуться наверх к меню

Какую схему питания УНЧ выбрать?

Для питания микросхемы, я решил использовать двухполярное питание.

При двухполярном питании не требуется бороться с фоном и щелчками при включении. Кроме того, отпадает необходимость в разделительных конденсаторах на выходе усилителя.

Ну, и самое главное, микросхемы, рассчитанные на однополярное питание и имеющие соизмеримый уровень искажений, в несколько раз дороже.

Это схема блока питания. В нём применён двухполярный двухполупериодный выпрямитель, которому требуются трансформатор с двумя совершенно одинаковыми обмотками «III» и «IV» соединёнными последовательно. Далее все основные расчёты будут вестись только для одной из этих обмоток.

Обмотка «II» предназначена для питания электронных регуляторов громкости, тембра и стереобазы, собранных на микросхеме TDA1524. Думаю описать темброблок в одной из будущих статей.

Ток, протекающий через обмотку «II» будет крайне мал, так как микросхема TDA1524 при напряжении питания 8,5 Вольта потребляет ток всего 35мА. Так что потребление здесь ожидается менее одного Ватта и на общей картине сильно не отразится.

Вернуться наверх к меню

Расчёт выходного напряжения (переменного тока) трансформатора работающего на холостом ходу или без существенной нагрузки.

Этот расчёт необходимо сделать, чтобы обезопасить микросхему от пробоя.

Максимальное допустимое напряжение питания TDA2030 – ±18 Вольт постоянного тока.

Для переменного тока, это будет:

18 / 1,41 ≈ 12,8 V

Падение напряжения на диоде* выпрямителя при незначительной нагрузке – 0,6 V.

12,8 + 0,6 = 13,4 V

*Схема применённого выпрямителя построена так, что протекающий в любом направлении ток создаёт падение напряжения только на одном из диодов. При использовании одной вторичной обмотки и мостового выпрямителя, таких диодов будет два.

При повышении напряжения сети, напряжение на выходе выпрямителя увеличится. По нормативам, напряжение сети должно быть в пределах – -10… +5% от 220-ти Вольт.

Уменьшаем напряжение на вторичной обмотке трансформатора для компенсации повышения напряжения сети на 5%.

13,4 * 0.95 ≈ 12,7 V

Мы получили значение максимального допустимого напряжения переменного тока на вторичной обмотке трансформатора при питании микросхемы TDA2030 от двухполярного источника без стабилизации напряжения.

Проще говоря, это чтобы напряжение не вылезло за пределы ±18V и не спалило микруху.

Те же значения для этой линейки микросхем.

| Тип микросхемы | На выходе трансформатора (~В) | Напряжение питания max (±В) |

| TDA2030 | 12,7 | 18 |

| TDA2040 | 14 | 20 |

| TDA2050 | 17,4 | 25 |

Вернуться наверх к меню

Расчёт напряжения (постоянного тока) на выходе блока питания работающего при максимальной нагрузке.

Этот расчёт необходимо сделать, чтобы оценить максимальную мощность на нагрузке и ограничить её путём снижения напряжения, если она выйдет за допустимые пределы для данного типа микросхемы или нагрузки.

Под нагрузкой напряжение переменного тока на вторичной обмотке понижающего трансформатора может уменьшиться.

12,7 * 0.9 ≈ 11,4V

Падение напряжения на диоде* выпрямителя резко возрастёт под нагрузкой и может достигнуть, в зависимости от типа диода, – 0.8… 1,5V.

11,4 – 1,5 = 9,9V

*Схема применённого выпрямителя построена так, что протекающий в любом направлении ток создаёт падение напряжения только на одном из диодов. При использовании одной вторичной обмотки и мостового выпрямителя, таких диодов будет два.

После выпрямителя получаем на конденсаторе фильтра напряжение постоянного тока:

9,9 * 1,41 ≈ 14V

Но, под нагрузкой, конденсатор не будет успевать заряжаться до максимально возможного напряжения. Поэтому, и в этом случае, исходное напряжение увеличивают на 10%.

14 * 0.9 = 12,6V

В реальности, действующее напряжение может быть и выше, а 12,6 Вольта, это тот уровень, на котором предположительно возникнет ограничение аудио сигнала. На картинке изображён эпюр напряжения на нагрузке, снятый при воспроизведении частоты синусоидального сигнала. Сигнал ограничен напряжением питания УНЧ.

При ограничении сигнала возникают сильные искажения, которые фактически и ограничивают выходную мощность УНЧ.

По даташиту, при напряжении питания ±12,6 Вольта и нагрузке 4 Ω, микросхема TDA2030 развивает синусоидальную мощность 9 Ватт. Этой мощности вполне хватит для моих скромных колонок и она не выйдет за пределы допуска для TDA2030.

Выходная мощность микросхем этой серии на нагрузке 4 Ω при использовании нестабилизированного блока питания с максимальным допустимым напряжением.

| Тип микросхемы | Мощность на нагрузке (Вт) | Напряжение питания на выходе БП под нагр. (±В) |

| TDA2030 | 9 | 12,6 |

| TDA2040 | 22 | 14 |

| TDA2050 | 35 | 18 |

Получив необходимые исходные данные, можно приступать к перемотке трансформатора.

Вернуться наверх к меню

Страницы 1 2 3 4

Как Сделать Трансформатор На 500 Вт Из Автотрансформатора Трансформатор Своими Руками

Как Сделать Трансформатор На 500 Вт Из Автотрансформатора Трансформатор Своими Руками. В этом ролике я покажу, как из автотрансформатора сделать трансформатор. Автотрансформатор будем снимать с стабилизатора напряжения Elim СНАП-500. Почему я решил снять автотрансформатор с этого стабилизатора, несмотря на то что он рабочий? На этом стабилизаторе стоит автотрансформатор на 500 ватт, а мне нужен трансформатор на 500 ватт. Я искал такой трансформатор везде, и в магазинах, и на авито и у знакомых электриков. Но нигде не нашел. Тогда я принял решение снять автотрансформатор с этого стабилизатора, и переделать его в трансформатор. Поддержите автора канала

— Обзор стабилизатора напряжения Elim СНАП-500

Электромеханический стабилизатор и реле напряжения

Установка и подключение китайского реле напряжения

Обзор ЛАТР SUNTEK 1000ВА, который будет подключаться к трансформатору.

Лучшие видео по ремонту

Лучшие видео по электрике

курс «Сам Себе Электрик»

00:00 — Как сделать трансформатор из автотрансформатора

00:34 — Почему я решил снять автотрансформатор со стабилизатора напряжения?

01:13 — Как снять автотрансформатор со стабилизатора напряжения?

01:34 — В чем сложность снятия автотрансформатора со стабилизатора.

01:51 — Какие выводы имеет снятый автотрансформатор?

02:44 — Как мы будем подключать первичную обмотку в наших опытах.

02:58 — Прозвонка обмотки автотрансформатора.

03:21 — Последовательность дальнейшей переделки автотрансформатора.

03:33 — Как определить, сколько витков нам нужно намотать во вторичной обмотке.

04:02 — Автотрансформатор после намотки тестовой обмотки.

04:18 — Замер выходного напряжения тестовой обмотки.

04:56 — Изоляция не используемых выводов автотрансформатора.

05:10 — Какие напряжения нам нужны на вторичной обмотке?

05:20 — Подсчет количества витков на вторичной обмотке.

05:56 — Наш трансформатор после намотки вторичной обмотки.

06:21 — Замер напряжения на вторичной обмотке.

06:43 — Вход и выход сделанного трансформатора.

07:04 — Возможности для апгрейда трансформатора.

07:11 — Теплоотвод трансформатора.

07:27 — Планы по размещению этого трансформатора в корпусе стабилизатора.

07:44 — Поддержите видео о реле напряжения лайком, репостом и комментарием.

Помогу развить ваш канал

Подпишитесь на наш канал

Консультация

Блог «Электрика и ремонт»

Мои книги

Мой аккаунт в соц-сети

Мой email msnbel />

Лучшие видео «Дом своими руками»

Лучшие видео «Электрика своими руками»

Лучшие видео «Сантехника своими руками»

Лучшие видео «Ремонт своими руками»

Лучшие видео «Профессия электрик, строитель»

- Категория

- Игры

Комментарии выключены

Вместе с Как Сделать Трансформатор На 500 Вт Из Автотрансформатора Трансформатор Своими Руками так же смотрят:

Самодельный трансформатор — Техножук

Изготовление трансформатора лучше всего начать с сердечника. Для сердечника надо нарезать из жести от консервных банок сорок пластин по рис. 71 а. Из этих пластин мы и соберем Ш-образный сердечник. Как видно из рисунка, средняя полоска пластинки несколько врезается в поперечную полоску. Пластинки вырубаются зубилом и после тщательно зачищаются напильником. Когда все пластинки нарезаны, их надо отжечь. Для этого пластинки кладут на горячие угли, потом в золу только что истопившейся печи и оставляют их там на несколько часов. После этого с пластин счищается окалина, и с одной стороны они покрываются лаком. Если не найдется зубила, то пластинки можно вырезать ножницами по рис. 71 б.

Изготовление трансформатора лучше всего начать с сердечника. Для сердечника надо нарезать из жести от консервных банок сорок пластин по рис. 71 а. Из этих пластин мы и соберем Ш-образный сердечник. Как видно из рисунка, средняя полоска пластинки несколько врезается в поперечную полоску. Пластинки вырубаются зубилом и после тщательно зачищаются напильником. Когда все пластинки нарезаны, их надо отжечь. Для этого пластинки кладут на горячие угли, потом в золу только что истопившейся печи и оставляют их там на несколько часов. После этого с пластин счищается окалина, и с одной стороны они покрываются лаком. Если не найдется зубила, то пластинки можно вырезать ножницами по рис. 71 б.

Пока пластинки сохнут, мы займемся изготовлением катушки трансформатора. Катушка склеивается из тонкого картона по рис.71 в.На сердечник катушки наматывается несколько слоев кальки и затем производится намотка проволоки.

Для первичной обмотки трансформатора на 120 вольт надо намотать 2500 витков изолированной эмалью проволоки диаметром 0,13мм. Прежде чем начинать намотку, к проволоке припаивается гибкий проводник сантиметров 15 длины, затем, обмотав его несколько раз вокруг сердечника, оставляют свободный конец в 6—7 см, и намотка катушки ведется ровным слоем по всей длине сердечника. К концу первичной обмотки также припаивается гибкий проводничсж и закрепляется на щечке катушки.

Покрыв первичную обмотку катушки несколькими слоями кальки, наматывают на нее в том же направлении вторичную обмотку. Для вторичной обмотки трансформатора надо намотать 120 витков изолированного эмалью провода диаметром 0,45мм. При этой обмотке мы сможем получать напряженнее 6 вольт, что вполне достаточно для питания лампы 6Ф6.

Рис. 71. Детали трансформатора.

а—шаблон пластин для сердечника трансформатора, б—можно вырезать пластины и так, в—каркас катушки трансформатора, г—готовый трансформатор „Гном\».

Закончив вторичную обмотку, катушку покрывают изоляционной лентой или же дерматином. Можно покрыть катушку и несколькими слоями кальки, а затем плотной бумагой. Всё это необходимо для предохранения обмотки от случайных повреждений.

Сборка трансформатора производится так: катушка кладется на стол, затем берется пластинка, средняя полоска несколько отгибается и вставляется в катушку. Вторую полоску вставляют в катушку с другой стороны, третью—так же, как и первую, и т. д. При сборке пластин следует обращать внимание на то, чтобы покрытая лаком сторона одной пластинки всегда ложилась .на непокрытую лаком сторону другой. В катушку надо вставить как можно больше пластин, чтобы сердечник был плотнее. Вставляя последние пластины будьте осторожны, чтобы не прорезать картон катушки и не повредить обмотку.

Собранный сердечник стягивается деревянными или металлическими планками на болтиках или же металлическими скобами. Готовый трансформатор „Гном\» показан на рис. 71г.

Обмотка собственных трансформаторов A M I F.

На рисунке 21 показаны все катушки, которые я намотал на шпульки до настоящего времени. Одна пустая шпулька служит для обозначения последних четырех, на которые нанесен клей Crystal Clear Gorilla Glue. Эти катушки были изготовлены с целью тестирования продукта, известного как Q Dope, на резиновый клей и клей Gorilla Glue. Q Dope выделяет довольно ядовитые пары, и я бы предпочел не использовать его. Добротность катушки, обработанной им, не лучше, чем у катушек, обработанных резиновым клеем.На самом деле это немного хуже, но при размере выборки в одну катушку нельзя делать однозначных выводов. Те, которые были обработаны клеем Crystal Clear Gorilla Glue, оказались лучше, чем резиновым клеем или Q Dope. Результаты приведены в таблице ниже.

| Таблица 2, добротность, индуктивность и резонанс C. | Измерено на частоте 790 кГц. | Измерено на частоте 455 кГц. | ||||

|---|---|---|---|---|---|---|

| Катушка # | Q | л (мГн) | Q | Cr (пФ) | л (мГн) Рассчитано | Легированный. |

| 1 | 97 | 0,92 | 83 | 147 | 0,832 | Резиновый цемент. |

| 2 | 80 | 0,93 | 82 | 149 | 0,821 | Q Допинг. |

| 3 | 99 | 0,860 | 82 | 148 | 0,827 | Резиновый цемент. |

| 4 | 104 | 0.915 | 83 | 146 | 0,838 | Резиновый цемент. |

| 5 | 99 | 0,94 | 84 | 144 | 0,850 | Резиновый цемент. |

| 6 | 105 | 0,925 | 84 | 140 | 0,874 | Резиновый цемент. |

| 7 | 98 | 0,98 | 81 | 140 | 0.874 | Резиновый цемент. |

| 8 | 88 | 0,915 | 71 | 149 | 0,821 | * Неправильная шпулька. |

| 9 | 103 | 0,905 | 84 | 148 | 0,827 | CCGG. |

| 10 | 95 | 0,905 | 82 | 146 | 0,838 | CCGG. |

| 11 | 94 | 0,950 | 84 | 146 | 0,838 | CCGG. |

| 12 | 94 | 0,920 | 83 | 146 | 0,838 | CCGG. |

CCGG = Кристально чистый клей гориллы.

* Легированный CCGG. Сью принесла домой не те шпульки. Я решил использовать один, чтобы посмотреть, как все пойдет.Все прошло не очень хорошо. И центральное отверстие, и отверстия для ввода и вывода проволоки необходимо было просверлить.

Единственный столбец в приведенной выше таблице, который требует небольшого пояснения, — это «Рассчитано L (мГн)» в столбце «Измерено на 455 кГц». Индуктивность рассчитывалась для каждого измерения по формуле

L = 1 / (4pi 2 f 2 C)Где L — индуктивность в генри, f — частота в герцах, а C — показание шкалы емкости в пикофарадах. Кажущееся несоответствие между значениями индуктивности при 790 и 455 кГц легко объяснить собственной емкостью катушки, из-за которой индуктивность кажется больше при измерении вблизи частоты собственного резонанса.

Q Dope неприятен в использовании, поэтому я сделал с ним только одну катушку. Резиновый клей, ну, резиновый клей. Кристально чистый клей Gorilla Glue — новый продукт, и читатель может быть с ним не знаком. Он почти не имеет запаха. При растирании между большим пальцем и пальцем появляется ощущение жирности. Нет ни малейшего признака того, что он хочет склеить пальцы. Поверхность становится липкой примерно через два часа после нанесения. После высыхания в течение ночи поверхность кажется твердой и сухой.При нанесении на катушку он впитывается так же быстро, как Q Dope, и оставляет отдельные витки четко видимыми. Обработанная часть змеевика выглядит немного темнее, чем необработанная.

Думаю, не многие из читателей этой статьи будут наматывать таким образом собственные катушки. Для дублирования моего проекта вам понадобятся два намотчика катушек Морриса. Мне дали тот, в котором не было проводника. Я нашел еще один на eBay, который выглядит так, как будто он был собран из частей нескольких единиц.Тем не менее, у меня была хорошая коллекция деталей и достаточно изобретательности, чтобы перепрофилировать некоторые обычные предметы и сделать работающий намотчик катушек.

Некоторые могут назвать меня ленивым из-за моторизации намоточного устройства, но я думаю, что это действительная модификация, которую другие, у кого уже есть намотчик, могут захотеть продублировать. С двигателем, обеспечивающим мощность, у меня есть обе руки, чтобы применить сопротивление к проводу, если необходимо, и наблюдать за процессом, чтобы убедиться, что все идет хорошо. Это далеко не то, чтобы повернуть рукоятку одной рукой, удерживать моталку от скольжения по скамейке другой и воздействовать на проволоку другой рукой.Подождите минуту. У меня просто кончились руки? Кроме того, я использовал шаговый двигатель и купил контроллер, вместо того, чтобы пытаться собрать его самостоятельно. Это означает, что двигатель может работать на части своей максимальной скорости и при этом работать так же плавно, как двигатель с пониженным редуктором. Я работал на нем со скоростью 1 оборот в секунду. Это означает, что на намотку катушки на 300 витков требуется 5 минут.

Капитан Кирк Скотти. «Вы спешите, мистер Скотт?»

Абсолютно постоянная скорость намотки должна приводить к более однородным катушкам.Стоимость двух двигателей и двух плат контроллеров плюс доставка из Китая составляла немногим более 100 долларов. Хотя многие веб-сайты говорят, что у них есть шаговые двигатели, большинство из них не дают спецификации крутящего момента, поэтому вы не можете быть уверены, что получаете двигатель, который будет выполнять эту работу.

Причина использования двух двигателей — мой план запустить вал катушки от одного двигателя и кулачковый вал от другого. Управляя скоростью двигателя с помощью Arduino, я могу установить любое передаточное число, которое захочу. Если вы не хотите заходить так далеко, вы можете моторизировать имеющуюся намоточную машину за половину стоимости.На данный момент я работаю с одним двигателем и использую передаточное число от 22 до 21, предоставленное господином Моррисом.

Проводник.

Деревянная часть направляющей для проволоки была вырезана из доски толщиной 3/4 дюйма, которую я купил в домашнем центре. Если вы не плотник, вам может показаться странным, что доску размером 3 и 1/2 на 3/4 дюйма называют 1 на 4. Поскольку вам нужен такой маленький кусок, вы должны попробовать пойти на склад пиломатериалов и просят просмотреть их записки. Они могут взимать символическую плату или просто дать вам небольшую сумму. Просверлите отверстие 1/4 дюйма в одном конце, как показано на Рисунке 10.

Выберите иглу с ушком, достаточно большим, чтобы позволить проволоке гладко проходить через нее.

Воткните эту иглу в торцевую жилу деревянной детали по центру, вверх, вниз и слева направо. Расположите нижний конец проушины над центром вала катушки.

Убедитесь, что игла вращается так, чтобы проволока проходила через ушко вертикально. См. Рисунок 22.

Процедура намотки катушки.

BERT для чайников — Пошаговое руководство | Мишель Кана, доктор философии

Чат-боты, виртуальный помощник и диалоговые агенты обычно классифицируют запросы по конкретным намерениям, чтобы генерировать наиболее последовательный ответ. Классификация намерений — это проблема классификации, которая предсказывает метку намерения для любого заданного пользовательского запроса. Обычно это проблема классификации нескольких классов, когда запросу присваивается одна уникальная метка. Например, запрос «сколько стоит услуга лимузина в Питтсбурге» обозначается как «Groundfare», а запрос «какой вид наземного транспорта доступен в Денвере» — как «ground_service».Запрос «я хочу вылететь из Бостона в 8:38 и прибыть в Денвер в 11:10» — это намерение «рейс», а «показать мне стоимость и время перелетов из Сан-Франциско в Атланту» — «авиабилеты + flight_time »намерение.

Примеры выше показывают, насколько неоднозначной может быть метка намерений. Пользователи могут добавлять вводящие в заблуждение слова, в результате чего в одном запросе присутствует несколько намерений. Для классификации намерений были предложены методы обучения на основе внимания (Liu and Lane, 2016; Goo et al., 2018). Один тип сети, построенной с особым вниманием, называется трансформатором . Он применяет механизмы внимания для сбора информации о релевантном контексте данного слова, а затем кодирует этот контекст в богатый вектор, который грамотно представляет это слово.

В этой статье мы продемонстрируем Transformer, особенно то, как его механизм внимания помогает в решении задачи классификации намерений путем изучения контекстных отношений. После демонстрации ограничений классификатора на основе LSTM мы представляем BERT: предварительное обучение глубоких двунаправленных преобразователей, новый подход преобразователя, предварительно обученный на больших корпусах и с открытым исходным кодом.В последней части этой статьи представлен код Python, необходимый для точной настройки BERT для задачи классификации намерений и достижения высочайшей точности в запросах с невидимыми намерениями. Мы используем набор данных ATIS (Airline Travel Information System), стандартный набор эталонных данных, широко используемый для распознавания намерений, стоящих за запросом клиента.

Данные

В одной из наших предыдущих статей вы найдете код Python для загрузки набора данных ATIS. В наборе данных обучения ATIS у нас есть 26 различных намерений, распределение которых показано ниже.Набор данных сильно несбалансирован, большинство запросов помечены как «полет» (код 14).

Мультиклассификатор

Прежде чем рассматривать Transformer, мы реализуем простую рекуррентную сеть LSTM для решения задачи классификации. После обычной предварительной обработки, токенизации и векторизации 4978 выборок подаются на слой Keras Embedding, который проецирует каждое слово как вложение Word2vec размерности 256. Результаты передаются через слой LSTM с 1024 ячейками. Это дает 1024 вывода, которые передаются на плотный слой с 26 узлами и активацией softmax.Вероятности, созданные в конце этого конвейера, сравниваются с исходными метками с использованием категориальной кроссэнтропии.

Как видно из результатов обучения выше, оптимизатор Adam застревает, потери и точность не улучшаются. Модель, кажется, предсказывает «полет» большинства классов на каждом этапе.

Когда мы используем обученную модель для прогнозирования намерений в невидимом тестовом наборе данных, матрица путаницы ясно показывает, насколько модель подходит для большинства «летных» классов.

Увеличение данных

Работа с несбалансированным набором данных — обычная проблема при решении задачи классификации. Увеличение объема данных — это то, что приходит на ум как хороший обходной путь. Здесь нередко можно встретить алгоритм SMOTE как популярный выбор для увеличения набора данных без искажения прогнозов. SMOTE использует классификатор k-ближайших соседей для создания синтетических точек данных в качестве многомерной интерполяции тесно связанных групп истинных точек данных. К сожалению, у нас есть 25 классов меньшинств в наборе данных обучения ATIS, в результате чего остается один слишком репрезентативный класс.SMOTE не работает, так как не может найти достаточно соседей (минимум 2). Передискретизация с заменой является альтернативой SMOTE, которая также не улучшает прогнозные характеристики модели.

Набор данных SNIPS, который собирается с помощью персонального голосового помощника Snips, более позднего набора данных для понимания естественного языка, представляет собой набор данных, который можно использовать для расширения набора данных ATIS в будущем.

Двоичный классификатор

Поскольку нам не удалось полностью расширить набор данных, сейчас мы скорее уменьшим масштаб проблемы.Мы определяем задачу бинарной классификации, в которой «полетные» запросы сравниваются с остальными классами, сворачивая их в один класс, называемый «другой». Распределение меток в этом новом наборе данных показано ниже.

Теперь мы можем использовать ту же сетевую архитектуру, что и раньше. Единственное изменение заключается в уменьшении количества узлов в плотном слое до 1, функции активации до сигмоида и функции потерь до бинарной кроссэнтропии. Удивительно, но модель LSTM все еще не может научиться предсказывать намерение, учитывая пользовательский запрос, как мы видим ниже.

Через 10 эпох мы оцениваем модель на невидимом тестовом наборе данных. На этот раз все образцы предсказываются как «другие», хотя «полет» имел в обучающем наборе более чем в два раза больше образцов, чем «другие».

Причина, по которой мы сейчас смотрим на Transformer, — это плохой результат классификации, который мы наблюдали с моделями от последовательности к последовательности в задаче Intent Classification, когда набор данных несбалансирован. В этом разделе мы представляем вариант Transformer и реализуем его для решения нашей проблемы классификации.Мы особенно внимательно рассмотрим опубликованные в конце 2018 года представления двунаправленного кодера от трансформаторов (BERT).

Что такое BERT?BERT — это, по сути, обученный стек Transformer Encoder, с двенадцатью в базовой версии и двадцатью четырьмя в большой версии, по сравнению с 6 уровнями кодировщика в исходном Transformer, который мы описали в предыдущей статье.

КодерыBERT имеют более крупные сети с прямой связью (768 и 1024 узлов в базовом и большом соответственно) и больше головок внимания (12 и 16 соответственно).BERT прошел обучение по Википедии и Книжному корпусу, набору данных, содержащему более 10 000 книг разных жанров. Ниже вы можете увидеть схему дополнительных вариантов BERT, предварительно обученных на специализированных корпусах.

исходный кодBERT был выпущен для общественности как новая эра в НЛП. Его код модели с открытым исходным кодом побил несколько рекордов для сложных языковых задач. Предварительно обученная модель на массивных наборах данных позволяет любому, кто занимается обработкой естественного языка, использовать этот бесплатный инструмент. Теоретически BERT позволяет нам пройти несколько тестов с минимальной тонкой настройкой под конкретную задачу.

(источник: Джей. Аламмар, 2018 г.)BERT работает аналогично стеку кодировщика Transformer, принимая в качестве входных данных последовательность слов, которые продолжают течь вверх по стеку от одного кодировщика к другому, пока поступают новые последовательности. вывод для каждой последовательности представляет собой вектор из 728 чисел в базовой версии или 1024 в большой версии. Мы будем использовать такие векторы для нашей задачи классификации намерений.

Зачем нам BERT?

Правильное представление языка является ключом к общему пониманию языка машинами. Контекстно-свободные модели , такие как word2vec или GloVe, генерируют представление встраивания одного слова для каждого слова в словаре. Например, слово «банк» будет иметь одинаковое представление в «банковский депозит» и «берег реки». Контекстные модели вместо этого генерируют представление каждого слова, основанное на других словах в предложении. BERT, как контекстная модель, двунаправленно фиксирует эти отношения. BERT был основан на недавней работе и умных идеях в области контекстных представлений перед обучением, включая полу-контролируемое последовательное обучение, генеративное предварительное обучение, ELMo, преобразователь OpenAI, ULMFit и преобразователь.Хотя все эти модели являются однонаправленными или неглубоко двунаправленными, BERT полностью двунаправлен.

Мы будем использовать BERT для извлечения высококачественных языковых функций из текстовых данных запроса ATIS и точной настройки BERT для конкретной задачи (классификации) с собственными данными для создания современных прогнозов.

Подготовка среды BERTНе стесняйтесь загрузить оригинальный блокнот Jupyter, который мы адаптируем для нашей цели в этом разделе.

Что касается среды разработки, мы рекомендуем Google Colab с предложением бесплатных графических процессоров и TPU, которые можно добавить, перейдя в меню и выбрав: Правка -> Настройки ноутбука -> Добавить ускоритель (GPU) .Альтернативой Colab является использование экземпляра JupyterLab Notebook на облачной платформе Google, выбрав меню AI Platform -> Notebooks -> New Instance -> Pytorch 1.1 -> With 1 NVIDIA Tesla K80 после запроса Google на увеличение вашего Квота GPU. Это будет стоить ок. 0,40 доллара в час (текущая цена, которая может измениться). Ниже вы найдете код для проверки доступности вашего графического процессора.

Мы будем использовать интерфейс PyTorch для BERT от Hugging Face, который на данный момент является наиболее широко распространенным и самым мощным интерфейсом PyTorch для работы с BERT.Hugging Face предоставляет репозиторий pytorch-transformers с дополнительными библиотеками для взаимодействия с более предварительно обученными моделями для обработки естественного языка: GPT, GPT-2, Transformer-XL, XLNet, XLM.

Как вы можете видеть ниже, для того, чтобы torch мог использовать графический процессор, вы должны идентифицировать и указать графический процессор в качестве устройства, потому что позже в цикле обучения мы загружаем данные на это устройство.

Теперь мы можем загрузить наш набор данных в экземпляр ноутбука. Пожалуйста, запустите код из нашей предыдущей статьи, чтобы предварительно обработать набор данных с помощью функции Python load_atis () , прежде чем двигаться дальше.

BERT ожидает входных данных в определенном формате с специальными маркерами для обозначения начала ([CLS]) и разделения / конца предложений ([SEP]). Кроме того, нам нужно разметить нашего текста в токены, соответствующие словарю BERT.

'[CLS] я хочу вылететь из Бостона в 838 и прибыть в Денвер в 1110 утра [SEP]' ['[CLS]', 'i', 'want', 'to', 'fly' , 'from', 'boston', 'at', '83', '## 8', 'am', 'and', 'прибыть', 'in', 'denver', 'at', '111' , '## 0', 'in', 'the', 'morning', '[SEP]']